最近akuma.aiが有名っぽいですね(情報古かったらすみません)。説明見てたのですが、似たようなものがComfyUIでも再現できそうな気がしたので試してみます。

Contents

ワークフロー

使用手順

1. ComfyUIの導入

以下の方法でComfyUIを導入します。

2. 拡張のインストール

以下の拡張をComfyUIにインストールしてください。(Manager経由がラクです)

3. モデルのダウンロードと配置

LCM-LoRAをダウンロードしてLoRA用のディレクトリに配置します。

4. ワークフローのインポート

以下のリンク先からダウンロードしてインポートします。

5. モデルの設定

Load LoRAノードにLCM-LoRAを設定し、Load Checkpointノードには好きなベースモデルを設定します。

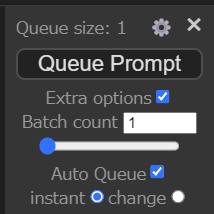

6. Auto Queueの設定

ペイントやパラメータが更新された場合に自動で生成処理が走るように設定します。

具体的には↓のようにExtra Optionsを設定します。

7. 生成する

Queue Promptすると、落書きから画像生成した結果がPreview Imageノードに反映されるようになります。

Tips

- プロンプトは生成したいものに合わせていじってください。EasyNegativeなどのembeddingを使用すると良い結果が出やすくなるかもしれません。

- 生成毎に違う画像になってしまうと困るので、seedは固定してあります。Primitiveノードで変更できるので、ハズレのseedだった場合は手動で変更してください。

- LCM-LoRAでなくともリアルタイムで生成できれば良いので、LightningやTurbo、Hyperモデルとかに置き換えても良いと思います。

生成結果

僕の絵が下手なのは気にせずお願いします…。

落書き

最後に

割といい感じに生成できているのではないでしょうか?動画がないのでわかりづらいですが、実際に試してみるとペイントした結果がほぼリアルタイムで反映されます。

無料で気軽に試せる点がオープンソースの強味だと思うので、面白そうって思った方はぜひ試してみてください。